Regulación de la Inteligencia Artificial: El desafío jurídico ante el avance tecnológico

Tiempo de lectura

4 minutos

Fecha

05/12/2024

Autor/a

Itziar Martínez

La inteligencia artificial (IA) está transformando la sociedad a un ritmo vertiginoso y su avance plantea desafíos profundos en el ámbito jurídico. El impacto de esta tecnología es innegable, pero actualmente la regulación sobre IA es escasa y está en una fase inicial. De hecho, tan sólo existe un reglamento de la Unión Europea como el primer intento significativo de establecer una norma, pero en términos generales, su entrada en vigor no será efectiva hasta el verano de 2026, dejando un vacío normativo en un campo en constante evolución.

Este ‘Reglamento Europeo de Inteligencia Artificial (AIA)’ tiene como objetivo garantizar un uso seguro y ético de la IA en toda la Unión Europea. Según el Ministerio de Asuntos Económicos y Transformación Digital, el AIA busca limitar los riesgos asociados a los sistemas de IA y los define como: «Aquellos que operan de forma autónoma mediante el análisis de datos y el aprendizaje automático. Además, la definición continúa reconociendo el impacto en el entorno: «Estos sistemas generan predicciones, recomendaciones o decisiones que influyen en el entorno con el que interactúan».

Mientras esperamos la implementación completa de este reglamento, el debate se centra en cómo mitigar los riesgos asociados a la IA, sin frenar su potencial innovador. En este contexto, abordar la necesidad de regulaciones provisionales y fomentar la colaboración entre actores legales, tecnológicos y gubernamentales es crucial para equilibrar su desarrollo.

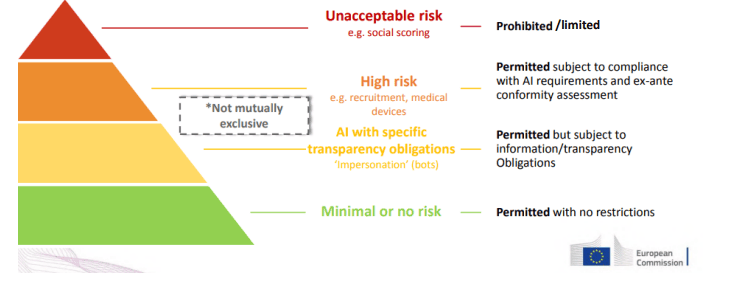

El Reglamento establece una jerarquía de riesgos en función del uso de la IA y sobre las categorías detectadas, determina una serie de obligaciones. Es el siguiente:

Mismo paradigma mundial, distintas formas de abordarlo

Borja García, responsable del área mercantil y contractual de Summons Abogados, con quien se realiza este artículo colaborativo, durante una jornada celebrada en la Autoridad Portuaria de Alicante bajo el título de “Transformación digital y legal: Emprendimiento, tecnología y el marco jurídico de la IA”, reconoció que «el mercado va muchísimo más rápido que la regulación» y añadió: «Hemos visto la evolución que ha tenido ChatGPT y el mercado va muy por delante de la regulación. Al no haber regulación, lo que prevalece es la autonomía de la voluntad entre las partes».

Durante la ponencia, se pusieron sobre la mesa las diferencias regulatorias, en materia de IA, entre China, Estados Unidos y Europa. En este sentido, Borja García señaló que cada región geopolítica ha adoptado una postura distinta: «China es la menos proactiva en cuanto a la regulación, porque desarrolla IA y es poco limitante, EE.UU está en un punto intermedio y la UE es el entorno en el que el esquema regulatorio es mayor «.

Por su parte, el abogado de Summons José María Espinosa, quien también participó en la ponencia, preguntó cuál es el camino correcto para abordar la cuestión, a lo que respondió: «Un equilibrio entre innovación y protección de los derechos humanos y de la libertad de empresa».

«La UE está regulando para tratar de proteger a los consumidores, entre otros, pero el Derecho siempre ha ido por detrás de la tecnología, y con IA el Derecho va 10 veces por detrás. Hay desprotección y por eso mismo la UE ha empezado a regular, pero será un proceso lento. Aunque yo pienso en positivo, porque al menos en la UE podemos encontrar mayor seguridad jurídica», manifestó Espinosa.

Innovación incluso en los contratos para paliar el vacío legal

Ante el vacío normativo, se está abriendo una vía práctica: La de, en caso de utilizar IA, establecer acuerdos contractuales, entre las partes implicadas, en las que se asumen responsabilidades de forma mutua para proteger los intereses de todos los involucrados. Todo ello porque no hay regulación y «no hay un marco legal que regule qué ocurre cuando se usa IA», señaló José María.

En un panorama donde la IA está cada vez más presente, la combinación de medidas contractuales, junto con un uso informado y consciente de estas tecnologías, se perfila como la mejor estrategia transitoria para garantizar la privacidad de los datos, una práctica ética y la tranquilidad de los usuarios.

Desde Summons se puso de ejemplo la experiencia de un abogado, quien presentó una querella de un cliente y el Tribunal Superior de Justicia de Navarra, tras su inadmisión a trámite, abrió una pieza separada parar analizar una posible negligencia del abogado por utilización de legislación de Colombia (en lugar de española). La cuestión derivó en otra investigación acerca del uso de ChatGPT en Justicia y la posible falta de revisión de los escritos generados por la IA. «Hay que tomar medidas para estar cubierto ante este tipo de situaciones», señaló Espinosa.

La seguridad de los datos del usuario, a debate

La privacidad de los datos de los usuarios que utilizan aplicaciones de inteligencia artificial como ChatGPT sigue siendo una preocupación. Según Borja García, aunque es posible preguntar directamente a ChatGPT Premium sobre el manejo de los datos, las respuestas que ofrece no son completamente claras, lo que deja espacio para la incertidumbre y la precaución.

En este contexto, José María Espinosa enfatizó en la importancia de usar herramientas especializadas según la naturaleza de la información. «Lo recomendable es utilizar ChatGPT para cuestiones menos técnicas y un software especializado para asuntos jurídicos, evitando así errores que puedan comprometer información sensible», señaló. Además, hizo un llamamiento a la calma recordando que empresas como Microsoft o plataformas como WhatsApp ya tienen acceso a datos sensibles de los usuarios debido a su utilización en la vida cotidiana. Sin embargo, esto no exime de actuar con prudencia, tomando medidas que minimicen riesgos.

Vendimia 6, 03320

Elche – Alicante

+34 900 83 12 52

consulting@zataca.com